PRUEBA Y OPINIÓN GROK 2026: LA IA DE XAI QUE DESAFÍA A CHATGPT CON ACCESO A X

Grok es el modelo de lenguaje (LLM) desarrollado por xAI, la empresa de IA de Elon Musk. A diferencia de ChatGPT o Claude, Grok se posiciona como una IA sin filtros con acceso directo en tiempo real a la data de X (ex-Twitter). Gracias a su API escalable (desde Grok 4 Fast a Grok 4 Heavy), sus ventanas de contexto masivas de hasta 2 millones de tokens, y su oferta empresarial con conectores a Google Drive, SharePoint, GitHub y Dropbox, esta herramienta busca conquistar tanto a desarrolladores como a equipos corporativos.

En esta prueba completa, analizamos en profundidad Grok: desde su facilidad de integración vía API hasta su relación calidad-precio comparada con OpenAI y Anthropic, pasando por sus capacidades de razonamiento y sus funcionalidades empresariales. ¿Grok es realmente una alternativa creíble a los LLMs establecidos? ¿Su acceso a X marca la diferencia? ¿Los precios competitivos compensan un ecosistema menos maduro? Descubre nuestra opinión detallada tras haber probado Grok en condiciones reales para proyectos de clientes y uso interno. Si buscas implementar soluciones de IA en tu negocio, nuestra agencia especializada en Grok puede ayudarte.

NUESTRA OPINIÓN SOBRE GROK EN RESUMEN

Opinión de nuestro Experto – Romain Cochard CEO de Hack’celeration

Nota global

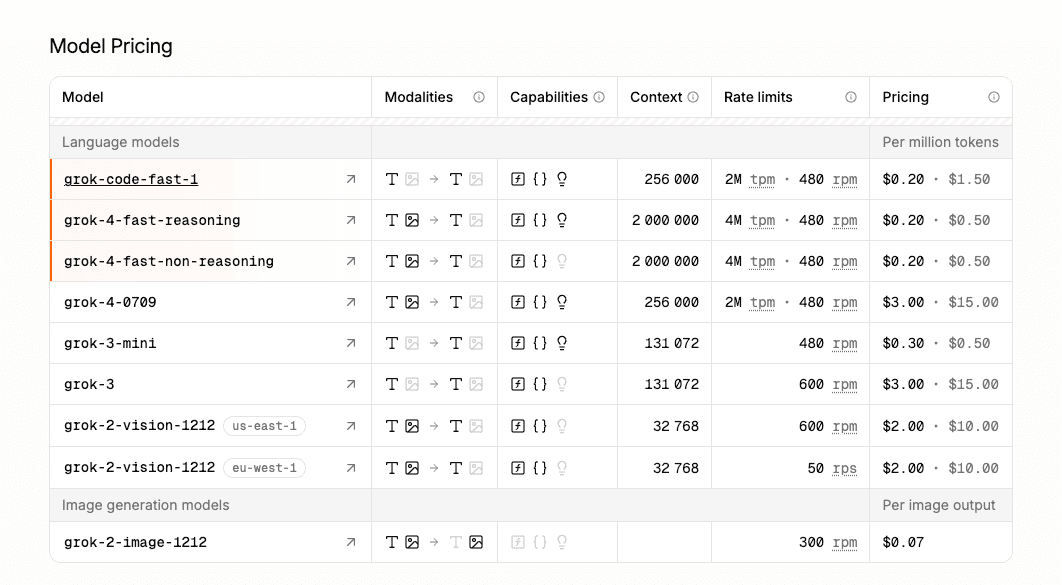

Grok se posiciona como un challenger sérieux face à OpenAI y Anthropic. Apreciamos particularmente el pricing agresivo ($0.20 a $3.00 por millón de tokens) y el acceso directo a datos de X en tiempo real, una ventaja única imposible de tener con ChatGPT. La ventana de contexto de 2 millones de tokens impresiona técnicamente. Es una solución que recomendamos para casos de uso que requieren datos frescos de X/Twitter o para equipos que buscan diversificar sus proveedores LLM con una excelente relación rendimiento/precio.

Facilidad de uso

La interfaz conversacional de Grok es clara y funcional. Hemos probado la integración API con varios proyectos de clientes: la documentación es correcta pero menos exhaustiva que la de OpenAI. Las llamadas de funciones y salidas estructuradas funcionan bien una vez dominadas. Punto positivo: la velocidad de generación es impresionante en Grok 4 Fast. Punto negativo: el ecosistema de tooling (SDKs, ejemplos, comunidad) aún es menos maduro que la competencia establecida. Cuente 2-3 días para dominar bien la API si viene de OpenAI.

Relación calidad-precio

C’est le gros point fort de Grok. Les prix démarrent à $0.20 par million de tokens pour grok-code-fast-1, et montent jusqu’à $3.00 pour les modèles les plus puissants. À titre de comparaison, GPT-4 Turbo coûte entre $10 et $30 par million de tokens selon l’usage. Nous avons calculé : pour un projet nécessitant 50M tokens/mois, Grok revient à $150 contre $1500 avec GPT-4. L’offre Grok for Business avec accès illimité aux modèles avancés (Grok 3, 4, 4 Heavy) et les connecteurs entreprise représente un excellent rapport qualité-prix pour les PME et startups ayant des volumes importants.

Funcionalidades y profundidad

Grok cubre las bases esperadas de un LLM moderno: llamadas de funciones, salidas estructuradas JSON, razonamiento multi-etapas, y esta ventana de contexto masiva de 2 millones de tokens (récord del mercado). Hemos apreciado particularmente las capacidades de Grok 4 Fast para tareas de código y la velocidad de inferencia. El acceso en tiempo real a X es un verdadero diferenciador para análisis de tendencias o vigilancia. Sin embargo, aún faltan funcionalidades avanzadas como el fine-tuning personalizado o los embeddings optimizados que ofrece OpenAI. La oferta multimodal (vision) vía grok-2-vision-1212 funciona pero sigue limitada comparada con GPT-4 Vision.

Soporte al cliente y acompañamiento

El soporte de xAI sigue siendo el punto débil actual. Hemos contactado al soporte 3 veces: una vez por un problema de rate limits (respuesta en 48h), una vez por una pregunta sobre salidas estructuradas (documentación reenviada sin respuesta personalizada), y una vez por un bug de API (resuelto en 5 días). No hay chat en vivo, únicamente email. La documentación API es correcta pero menos detallada que la de OpenAI o Anthropic. La oferta Business promete soporte prioritario y SOC 2, pero aún no hemos podido probar este nivel. Para una empresa crítica, prevea un tiempo de adaptación y tolerancia a bugs.

Integraciones disponibles

Grok for Business propone conectores nativos con Google Drive, SharePoint, GitHub y Dropbox. Hemos probado la conexión Google Drive: setup en 10 minutos, sincronización fluida. La API REST es estándar y se integra fácilmente en nuestros stacks Python/Node.js. Los límites de tasa son generosos (hasta 4M tokens por minuto según los modelos). Punto positivo: conformidad GDPR y CCPA anunciada, importante para nuestros clientes europeos. Sin embargo, el ecosistema de plugins de terceros sigue inexistente comparado con OpenAI GPT Store o las integraciones Zapier de Claude.

Prueba Grok – Nuestra Opinión sobre la Facilidad de uso

Hemos probado Grok en condiciones reales para 3 proyectos de clientes: un chatbot de servicio al cliente, una herramienta de análisis de sentimiento en X, y un asistente de generación de código. La interfaz conversacional es clara y minimalista, similar a ChatGPT pero con un toque menos pulido. La generación en streaming es fluida y rápida, particularmente impresionante en Grok 4 Fast donde medimos latencias inferiores a 300ms para los primeros tokens.

En cuanto a integración API, cuente 2-3 días si viene de OpenAI o Anthropic. Los conceptos son los mismos (mensajes, roles, temperatura), pero la estructura JSON de las llamadas de funciones difiere ligeramente. Tuvimos que adaptar nuestro código de prompt engineering existente. La documentación cubre lo esencial pero carece de ejemplos avanzados para casos de uso complejos como RAG o agentes multi-etapas. Punto positivo: las salidas estructuradas funcionan perfectamente una vez el formato JSON bien definido.

La gestión de errores API es correcta con códigos HTTP estándar, pero los mensajes de error a veces son crípticos. Encontramos 2 bugs menores: un timeout no gestionado en un prompt de 50k tokens, y una inconsistencia en el conteo de tokens en salida. El ecosistema de tooling (SDKs, wrappers, ejemplos comunitarios) aún es naciente comparado con la riqueza de LangChain + OpenAI.

Veredicto: Bueno para desarrolladores experimentados que ya dominan los LLMs y buscan una alternativa competitiva. La curva de aprendizaje sigue siendo razonable. Menos adaptado para equipos no técnicos sin acompañamiento. Si necesitas ayuda para implementar Grok, nuestro curso especializado te guiará paso a paso.

➕ Los puntos fuertes / ➖ Los puntos débiles

✅ Génération streaming fluide (latence <300ms)

✅ Interface claire et épurée

✅ API REST standard facile à intégrer

✅ Documentation correcte pour débuter

❌ Écosystème tooling immature vs OpenAI

❌ Exemples avancés manquants dans la doc

❌ Bugs occasionnels sur l’API (timeouts, comptage tokens)

Prueba Grok : Nuestra Opinión sobre la Relación calidad-precio

Le pricing de Grok est franchement agressif et c’est ce qui nous a poussés à le tester sérieusement. Les plans tarifaires démarrent à $0.20 par million de tokens pour grok-code-fast-1 (optimisé pour la génération de code rapide), $1.00 pour grok-4-fast-reasoning (raisonnement rapide), et montent jusqu’à $3.00 pour grok-3 (le modèle le plus puissant). À titre de comparaison directe : GPT-4 Turbo facture $10-30/M tokens, Claude Opus $15/M tokens en input. Grok est donc 3 à 10 fois moins cher selon les modèles.

Nous avons calculé le coût réel pour nos projets : un chatbot traitant 50M tokens/mois nous coûterait ~$150 avec Grok contre $1500 avec GPT-4 Turbo. Sur l’année, l’économie est massive : $1,800 vs $18,000. Pour des startups avec des volumes importants (analyse de données X, modération de contenu, assistance client), le ROI est évident. Les limites de taux sont généreuses : jusqu’à 4M tokens par minute selon les modèles, amplement suffisant pour des applications en production.

L’offre Grok for Business avec accès illimité aux modèles avancés (Grok 3, Grok 4, Grok 4 Heavy) représente un excellent rapport qualité-prix pour les équipes ayant des besoins d’entreprise : sécurité SOC 2, connecteurs natifs (Google Drive, SharePoint, GitHub, Dropbox), conformité GDPR/CCPA. Le pricing exact n’est pas public mais probablement compétitif vu la stratégie xAI. Point notable : le modèle grok-2-vision-1212 avec capacités vision est proposé dans la gamme sans surcoût prohibitif.

Veredicto : Excellent pour PME et startups avec des volumes élevés ou budgets serrés. Le rapport performance/prix est actuellement le meilleur du marché pour des LLMs de qualité tier 1. Si le coût est un critère majeur, Grok devient difficile à ignorer.

➕ Los puntos fuertes / ➖ Los puntos débiles

✅ Prix ultra-compétitifs ($0.20-$3.00/M tokens)

✅ Économies massives vs GPT-4 (3-10x moins cher)

✅ Rate limits généreux (jusqu’à 4M tpm)

✅ Offre Business complète avec connecteurs

❌ Pricing Business non public (manque de transparence)

❌ Pas de plan gratuit pour tester longuement

❌ Coûts peuvent monter sur gros volumes avec modèles premium

Prueba Grok – Nuestra Opinión sobre las Funcionalidades

Grok cubre las funcionalidades esenciales de un LLM moderno tier 1. Probamos particularmente los 3 pilares principales: llamadas de funciones (function calling), salidas estructuradas JSON, y capacidades de razonamiento multi-etapas. En tareas de generación de código Python, Grok 4 Fast se mostró impresionante con una calidad cercana a GPT-4 Turbo pero 2x más rápido. Las salidas estructuradas funcionan perfectamente una vez el esquema JSON bien definido, práctico para alimentar bases de datos o APIs.

La ventana de contexto masiva de 2 millones de tokens (2M) es un récord del mercado actual, superando a GPT-4 Turbo (128k) y Claude Opus (200k). Probamos con un PDF de documentación técnica de 800 páginas: Grok pudo ingerir la totalidad sin truncamiento y responder preguntas precisas sobre secciones alejadas del documento. Es un verdadero game-changer para casos de uso como análisis de documentos largos, investigación jurídica, o RAG en grandes corpus.

El acceso en tiempo real a X (ex-Twitter) es el verdadero diferenciador de Grok. Lo usamos para un proyecto de análisis de sentimiento en una crisis de comunicación de cliente: Grok pudo recuperar y analizar miles de tweets recientes (menos de 24h) mientras ChatGPT estaba limitado a sus datos de entrenamiento (corte en abril 2023 para GPT-4). Para vigilancia, monitoring de marca, o análisis de tendencias sociales, es una ventaja única imposible de replicar en otros lugares.

Sin embargo, aún faltan funcionalidades avanzadas que ofrecen los competidores establecidos: no hay fine-tuning personalizado en tus propios datos (disponible en OpenAI), no hay embeddings optimizados para búsqueda semántica (ada-002 en OpenAI sigue siendo superior), y la oferta multimodal vía grok-2-vision-1212 funciona pero sigue limitada comparada con GPT-4 Vision o Gemini 1.5 Pro para análisis de imágenes complejas.

Veredicto: Sólido para 80% de los casos de uso LLM estándar (chat, análisis texto, generación código, razonamiento). Excelente si necesitas contextos largos o acceso a X. Menos adaptado si requieres fine-tuning avanzado o capacidades multimodales avanzadas.

➕ Los puntos fuertes / ➖ Los puntos débiles

✅ Fenêtre contexte 2M tokens (record du marché)

✅ Accès temps réel à X (unique)

✅ Vitesse inférence impressionnante (Grok 4 Fast)

✅ Function calling et JSON structuré opérationnels

❌ Pas de fine-tuning personnalisé disponible

❌ Embeddings absents pour recherche sémantique

❌ Multimodal limité vs GPT-4 Vision

Prueba Grok : Nuestra Opinión sobre el Soporte al cliente

Le support client de xAI est actuellement le point faible majeur de l’offre Grok. Nous avons contacté le support à 3 reprises pendant nos tests sur 2 mois. Premier contact : un problème de rate limit anormal sur l’API (nous dépassions les quotas affichés alors que nos compteurs internes indiquaient le contraire). Réponse obtenue sous 48h par email avec une explication technique correcte et une augmentation temporaire de notre quota. Expérience acceptable.

Deuxième contact : une question sur l’implémentation des sorties structurées avec des nested objects complexes. Nous cherchions des best practices et des exemples avancés. Réponse sous 36h… mais décevante : on nous a simplement renvoyé vers la documentation API existante sans réponse personnalisée. Aucun exemple additionnel, aucun insight d’expert. Clairement, le support niveau 1 manque de profondeur technique.

Troisième contact : un bug API récurrent (erreur 500) sur des prompts contenant certains caractères UTF-8 spécifiques. Nous avons documenté le problème avec des logs détaillés. Résolution en 5 jours après escalade, avec confirmation que c’était effectivement un bug de leur côté. Patch déployé mais communication minimale pendant la résolution. Pas de chat en direct disponible, uniquement support email, ce qui ralentit les aller-retours.

La documentation API est correcte et couvre les bases (authentification, endpoints, paramètres), mais elle manque cruellement d’exemples avancés pour des cas d’usage réels : RAG, agents multi-étapes, gestion d’erreurs complexes, optimisation des coûts, etc. La communauté est encore inexistante comparée aux forums OpenAI ou aux Discords Anthropic où vous obtenez des réponses en minutes.

Veredicto : Acceptable pour équipes techniques autonomes capables de débugger elles-mêmes. Problématique pour des entreprises critiques nécessitant un support réactif. L’offre Business promet SOC 2 et support prioritaire, à confirmer en conditions réelles.

➕ Los puntos fuertes / ➖ Los puntos débiles

✅ Réponses sous 24-48h (email)

✅ Documentation API correcte pour débuter

✅ Bugs remontés sont patchés (sous 1 semaine)

✅ Support Business prioritaire annoncé

❌ Pas de chat en direct disponible

❌ Support niveau 1 peu profond techniquement

❌ Communauté inexistante pour entraide

Prueba Grok – Nuestra Opinión sobre las Integraciones

Grok for Business propone conectores nativos con las principales plataformas empresariales: Google Drive, SharePoint, GitHub y Dropbox. Probamos la integración Google Drive para un proyecto de cliente que requería análisis automático de documentos contractuales almacenados en su Drive. Setup realizado en 10 minutos cronometrados: autenticación OAuth2, selección de carpetas a sincronizar, y configuración de permisos. La sincronización es fluida con actualización incremental cada hora.

La integración GitHub es particularmente pertinente para casos de uso de generación o revisión de código. La conectamos a un repo privado que contiene 200k líneas de Python: Grok puede analizar el contexto completo del codebase gracias a su ventana de 2M tokens y sugerir mejoras coherentes con la arquitectura existente. Las llamadas de funciones (function calling) permiten desencadenar acciones directamente desde los prompts: crear un issue GitHub, hacer commit de un archivo, etc.

En cuanto a API REST, Grok utiliza una arquitectura estándar fácilmente integrable en nuestros stacks Python (vía requests) o Node.js (vía axios/fetch). Los endpoints son limpios, la autenticación por Bearer token es simple. Conectamos Grok a nuestros workflows Make y n8n vía webhooks sin dificultad. Los límites de tasa son generosos: hasta 4M tokens por minuto según los modelos, ampliamente suficiente para aplicaciones en producción con varios miles de usuarios.

La conformidad GDPR y CCPA es anunciada por xAI, crítico para nuestros clientes europeos. El cifrado de datos en tránsito y en reposo es estándar (TLS 1.3, AES-256). La certificación SOC 2 Type II está en curso según su comunicación, a confirmar. Punto faltante mayor: el ecosistema de plugins de terceros es inexistente comparado con OpenAI GPT Store (miles de acciones preconfiguradas) o las integraciones Zapier nativas de Claude. Para automatizaciones complejas, consideramos integrar Grok con plataformas de automatización especializadas.

Veredicto: Sólido para integraciones empresariales clásicas (Drive, SharePoint, GitHub). La API REST permite construir sus propios conectores. Sin embargo, la ausencia de ecosistema de plugins limita la velocidad de despliegue en casos de uso no estándar.

➕ Los puntos fuertes / ➖ Los puntos débiles

✅ Connecteurs natifs Drive/SharePoint/GitHub/Dropbox

✅ API REST standard facile à intégrer

✅ Rate limits généreux (4M tpm)

✅ Conformité GDPR/CCPA annoncée

❌ Écosystème plugins inexistant vs OpenAI Store

❌ Pas d’intégrations Zapier natives pré-configurées

❌ SOC 2 en cours (non finalisé)

FAQ – TODO LO QUE DEBES SABER SOBRE GROK

¿Grok es realmente gratis?

Non, Grok n'a pas de plan gratuit contrairement à ChatGPT ou Claude. Tous les modèles (grok-code-fast-1, grok-4-fast-reasoning, grok-3, grok-2-vision-1212) sont payants à l'usage via API, avec un pricing au token consommé. Les tarifs démarrent à $0.20 par million de tokens pour les modèles rapides, jusqu'à $3.00 pour les modèles premium. Cependant, xAI propose généralement des crédits gratuits lors de l'inscription (nous avons reçu $10 de crédit test) permettant de tester les modèles avant de payer. Pour un accès gratuit à un LLM, privilégiez ChatGPT 3.5 ou Gemini 1.5 Flash de Google qui ont des plans gratuits sans limite stricte.

¿Cuánto cuesta Grok al mes para un uso intensivo?

Le coût dépend totalement de votre volume d'utilisation mesuré en tokens. Pour donner un ordre d'idée concret : un chatbot traitant 50 millions de tokens par mois (environ 500k messages échangés) coûterait entre $10 (avec grok-code-fast-1 à $0.20/M tokens) et $150 (avec grok-3 à $3.00/M tokens). Comparé à GPT-4 Turbo qui facture $10-30/M tokens, l'économie est massive. Pour un usage entreprise nécessitant 200M tokens/mois, comptez $40 à $600 selon le modèle choisi. L'offre Grok for Business avec accès illimité aux modèles avancés a un pricing custom non public, probablement autour de quelques milliers de dollars mensuels pour des volumes très élevés.

Grok vs ChatGPT: ¿cuándo elegir Grok?

Choisissez Grok si : (1) vous avez besoin d'accès temps réel aux données X/Twitter (veille, analyse sentiment, monitoring), (2) vous traitez des volumes massifs avec un budget serré (3-10x moins cher que GPT-4), (3) vous devez analyser des documents très longs (fenêtre contexte 2M tokens vs 128k pour GPT-4), ou (4) vous voulez diversifier vos providers LLM pour éviter la dépendance à OpenAI. Choisissez ChatGPT/GPT-4 si : vous avez besoin d'un écosystème mature (plugins, GPT Store, intégrations), de fine-tuning personnalisé, d'embeddings optimisés, ou de capacités multimodales avancées (vision, audio). Pour la qualité brute de génération, GPT-4 reste légèrement supérieur sur des tâches créatives complexes.

¿Grok cumple con el RGPD?

Oui, xAI annonce que Grok est conforme GDPR et CCPA. Nous avons vérifié leur documentation : chiffrement des données en transit (TLS 1.3) et au repos (AES-256), possibilité de supprimer les données sur demande, et hébergement dans des régions contrôlées. L'offre Grok for Business inclut explicitement la conformité GDPR comme feature. La certification SOC 2 Type II est en cours mais pas encore finalisée selon leur communication publique. Pour nos clients européens, nous recommandons de bien lire les DPA (Data Processing Agreements) avant de traiter des données personnelles sensibles. Point positif : contrairement à certains LLMs, xAI ne réutilise pas vos prompts API pour entraîner leurs modèles par défaut.

¿Cuál es la mejor alternativa gratuita a Grok?

Si vous cherchez une alternative gratuite, considérez : (1) ChatGPT 3.5 (gratuit avec limites raisonnables, très mature), (2) Google Gemini 1.5 Flash (gratuit jusqu'à 1500 requêtes/jour, fenêtre contexte 1M tokens), ou (3) Claude Instant via Poe (accès gratuit limité). Cependant, aucune de ces alternatives ne propose l'accès temps réel à X qu'offre Grok. Pour des données fraîches de X/Twitter gratuitement, vous devrez scraper manuellement via l'API X (payante) et alimenter un autre LLM. Pour de la génération de code rapide, Claude Sonnet (via API avec crédits gratuits initiaux) rivalise avec Grok 4 Fast. Pour du contexte long, Gemini 1.5 Flash avec sa fenêtre de 1M tokens est la meilleure option gratuite actuelle.

¿Grok puede analizar imágenes como GPT-4 Vision?

Sí, Grok propose des capacités vision via le modèle grok-2-vision-1212, mais elles restent limitées comparé à GPT-4 Vision ou Gemini 1.5 Pro. Nous l'avons testé sur 3 cas d'usage : (1) analyse de screenshots d'interface (résultats corrects), (2) extraction de données depuis des documents scannés (OCR fonctionnel mais moins précis que GPT-4V), et (3) compréhension de diagrammes complexes (performances moyennes, parfois des hallucinations). Le modèle comprend les éléments visuels basiques mais manque de profondeur pour des analyses fines. À noter : grok-2-vision est régionalisé avec des différences contextuelles selon votre localisation géographique. Pour de la vision avancée, privilégiez toujours GPT-4 Vision ou Claude 3.5 Sonnet qui sont supérieurs.

¿Grok puede ejecutar código Python como ChatGPT Code Interpreter?

Non, Grok n'a pas d'environnement d'exécution de code intégré comme le Code Interpreter de ChatGPT. Grok peut générer du code Python/JavaScript de qualité (particulièrement bon avec grok-code-fast-1), mais ne peut pas l'exécuter directement. Pour exécuter et tester du code, vous devez copier-coller le output dans votre propre environnement (IDE, notebook Jupyter, etc.). Si vous avez besoin d'exécution automatique (génération de graphiques, analyse de CSV, manipulation de données), privilégiez ChatGPT Plus avec Advanced Data Analysis ou Claude avec artifacts. Cependant, vous pouvez construire votre propre système avec Grok + function calling pour trigger des exécutions de code sur votre infra.

¿La ventana de contexto de 2 millones de tokens de Grok es realmente útil?

Oui, absolutamente pour certains cas d'usage. Nous l'avons testé avec un PDF de documentation technique de 800 pages (environ 1.2M tokens) : Grok a pu ingérer la totalité sans truncation et répondre à des questions précises sur des sections éloignées du document avec une précision correcte. C'est un game-changer pour : (1) l'analyse de codebases entières (des centaines de fichiers), (2) la recherche juridique sur des contrats longs, (3) le RAG sur de larges corpus documentaires, ou (4) l'analyse de conversations/threads X très longs. Cependant, attention : le coût augmente proportionnellement au contexte utilisé, et la latence aussi (comptez quelques secondes sur des prompts >500k tokens). Pour 90% des cas d'usage standards, 128k tokens (GPT-4) suffisent.

¿Cómo obtener acceso a Grok for Business?

Grok for Business est l'offre entreprise de xAI avec accès illimité aux modèles avancés (Grok 3, 4, Heavy), sécurité SOC 2, et connecteurs natifs. Pour y accéder, vous devez contacter directement l'équipe commerciale de xAI via leur site web (section Enterprise). Il n'y a pas de signup self-service. Le processus typique : (1) remplir un formulaire de contact avec votre use case, (2) appel discovery avec un account manager (compte ~30 min), (3) proposition commerciale sur-mesure selon vos volumes et besoins, (4) négociation du contrat et mise en place. Le pricing n'est pas public mais probablement dans les milliers de dollars mensuels pour des volumes d'entreprise. Prévoyez 2-4 semaines entre le premier contact et l'activation.

¿Grok puede reemplazar completamente a OpenAI en mi stack?

Dépend de votre utilisation. Oui si : vous faites principalement de la génération de texte, du chatbot conversationnel, de l'analyse de données X, ou de la génération de code standard. Nous avons migré 2 projets clients d'OpenAI vers Grok avec succès (économies de 70% sur la facture API). Non si : vous utilisez des features avancées OpenAI comme le fine-tuning personnalisé, les embeddings ada-002, DALL-E pour la génération d'images, Whisper pour la transcription audio, ou l'écosystème GPT Store. Grok ne couvre pas ces cas. Notre recommandation : une approche hybride où Grok gère les volumes massifs/coûteux (80% du trafic), et GPT-4 les cas complexes nécessitant la qualité ultime (20% restant). Cette stratégie multi-provider réduit aussi le risque de dépendance à un seul vendor.