INTÉGRATION AWS S3 N8N : AUTOMATISER AWS S3 AVEC N8N

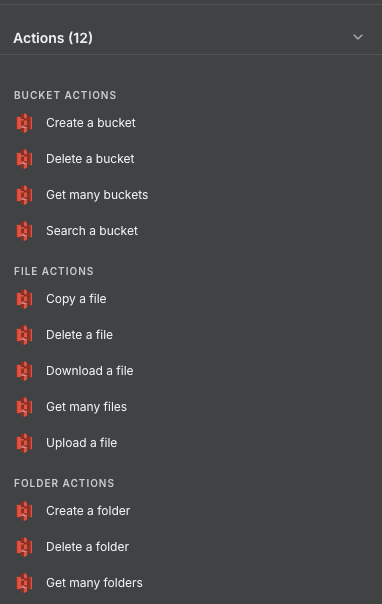

Vous cherchez à automatiser la gestion de vos fichiers et buckets AWS S3 directement depuis n8n ? L’intégration native AWS S3 dans n8n vous offre 12 actions pour piloter l’intégralité de vos opérations de stockage cloud sans quitter votre workflow d’automatisation.

Que vous ayez besoin de créer des buckets à la volée, d’uploader des fichiers automatiquement après un traitement, de synchroniser des dossiers entre applications ou de nettoyer des ressources obsolètes, cette intégration couvre tous les cas d’usage. Concrètement, vous pouvez gérer vos buckets (création, suppression, recherche), manipuler vos fichiers (upload, download, copie, suppression) et organiser vos dossiers — le tout orchestré par notre agence n8n. Découvrez comment exploiter pleinement cette intégration pour automatiser vos flux de données cloud.

Workflow n8n AWS S3 : démonstration d'une automatisation connectant AWS S3 à d'autres applications via n8n. Cette vidéo illustre comment les actions AWS S3 s'intègrent dans un workflow n8n pour automatiser vos processus de stockage cloud sans code.

POURQUOI AUTOMATISER AWS S3 AVEC N8N ?

L’intégration AWS S3 n8n met à votre disposition 12 actions couvrant trois types de ressources : les buckets, les fichiers et les dossiers. Cette richesse fonctionnelle vous permet d’automatiser pratiquement toutes les opérations de stockage que vous effectuez manuellement dans la console AWS — mais en les connectant à des centaines d’autres applications.

Gain de temps considérable : plus besoin de jongler entre la console AWS, vos outils métier et vos scripts maison. Configurez des workflows qui automatisent l’upload des pièces jointes de vos emails, sauvegardent les exports de vos bases de données ou archivent les fichiers traités. Réactivité améliorée : dès qu’un événement se produit dans une autre application (nouveau lead, commande validée, rapport généré), déclenchez instantanément l’action S3 correspondante. Intégration fluide : connectez AWS S3 à plus de 400 applications dans n8n — CRM, outils de productivité, bases de données, services d’emailing.

Exemples concrets de workflows : sauvegarder automatiquement les factures générées dans un bucket dédié, synchroniser les assets uploadés sur votre CMS vers S3, archiver les pièces jointes des tickets support, ou encore nettoyer automatiquement les fichiers temporaires après traitement. En quelques minutes de configuration, vous éliminez des heures de manipulations manuelles répétitives.

COMMENT CONNECTER AWS S3 À N8N ?

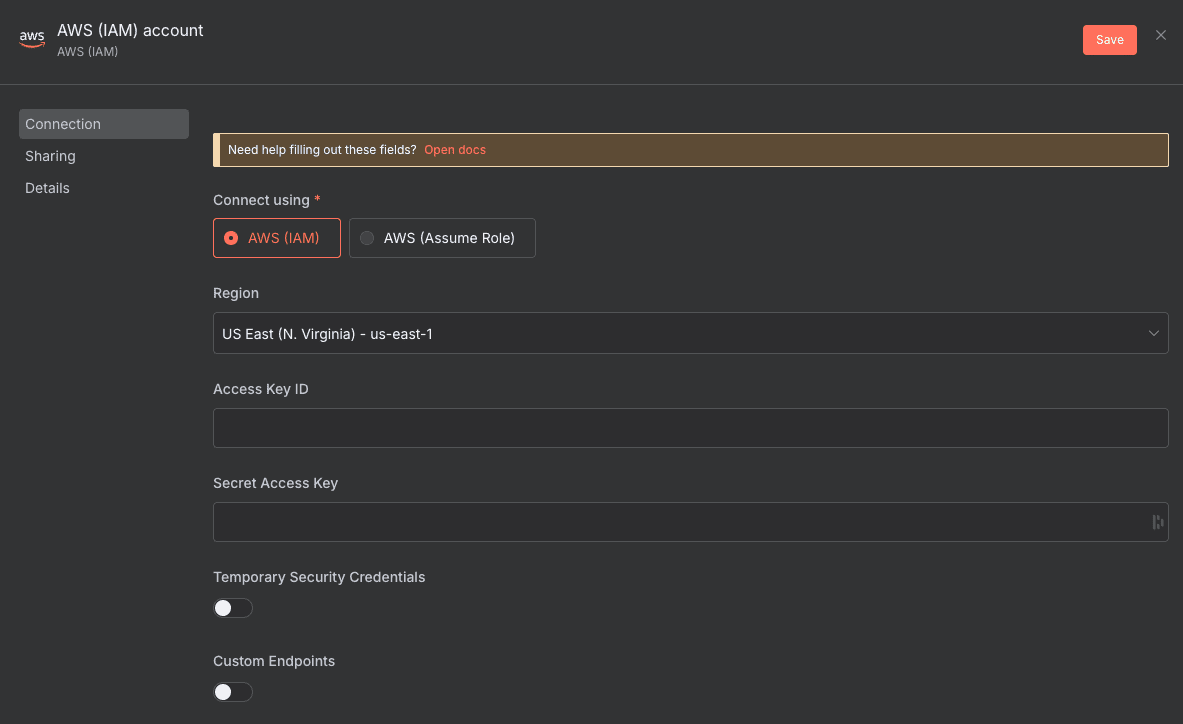

L’authentification AWS S3 dans n8n s’effectue via vos identifiants IAM (Identity and Access Management). Vous aurez besoin de votre Access Key ID et de votre Secret Access Key, récupérables depuis la console AWS IAM.

Configuration de base :

- Créez un utilisateur IAM dédié : dans la console AWS, accédez à IAM > Users > Add user. Créez un utilisateur avec un accès programmatique et attachez-lui une politique autorisant les opérations S3 nécessaires (AmazonS3FullAccess pour un accès complet, ou une politique personnalisée plus restrictive).

- Récupérez vos clés d’accès : une fois l’utilisateur créé, notez l’Access Key ID et le Secret Access Key. Attention : le Secret Access Key ne s’affiche qu’une seule fois.

- Configurez les credentials dans n8n : dans n8n, ajoutez un nouveau credential de type « AWS ». Renseignez votre Access Key ID, Secret Access Key, et sélectionnez la région AWS où se trouvent vos buckets.

- Testez la connexion : ajoutez un nœud AWS S3 à votre workflow et sélectionnez vos credentials. Lancez une action simple (comme « Get Many Buckets ») pour valider que tout fonctionne.

💡 TIPS : Créez toujours un utilisateur IAM dédié à n8n plutôt que d’utiliser vos credentials personnels. Appliquez le principe du moindre privilège : n’accordez que les permissions S3 strictement nécessaires à vos workflows. Ça limite les risques en cas de fuite des credentials.

BESOIN D’AIDE POUR AUTOMATISER AWS S3 AVEC N8N ?

On revient vers vous en quelques minutes ✔

ACTIONS AWS S3 DISPONIBLES DANS N8N

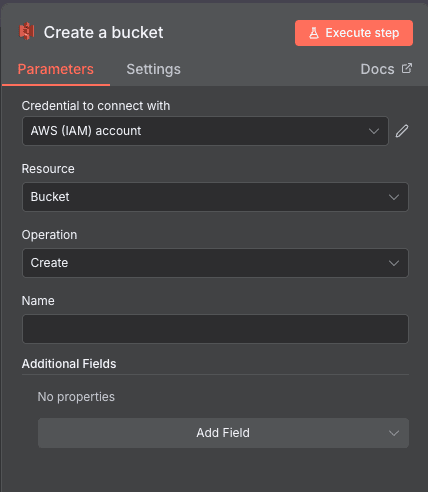

Create a bucket

Cette action vous permet de créer un nouveau bucket S3 directement depuis votre workflow d’automatisation n8n. Particulièrement utile pour les scénarios où vous devez provisionner dynamiquement des espaces de stockage — par exemple, créer un bucket dédié pour chaque nouveau client ou projet.

Paramètres de configuration : Credential to connect with (sélectionnez vos identifiants IAM AWS, requis), Resource (fixé sur « Bucket »), Operation (fixé sur « Create »), Name (champ texte pour le nom du bucket, requis, doit respecter les conventions de nommage S3), Additional Fields (section optionnelle pour configurations supplémentaires comme région, ACL, versioning).

Cas d’usage typiques : Créer automatiquement un bucket de stockage lors de l’onboarding d’un nouveau client, provisionner des espaces de backup dédiés par projet, générer des buckets temporaires pour des traitements batch.

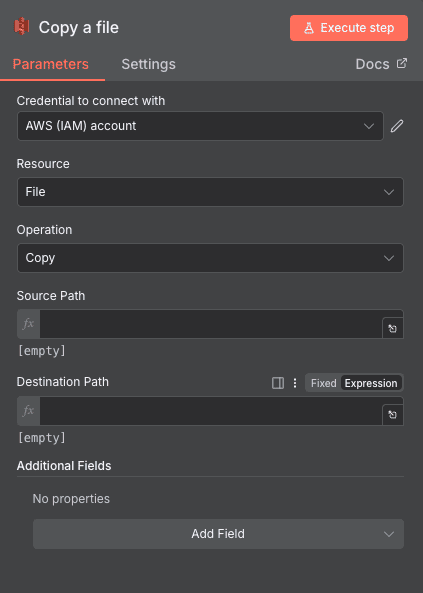

Copy a file

Cette action copie un fichier d’un emplacement à un autre au sein de S3. Utile pour la réorganisation automatique, l’archivage ou la duplication de fichiers.

Paramètres de configuration : Credential to connect with (identifiants IAM, requis), Resource (fixé sur « File »), Operation (fixé sur « Copy »), Source Path (chemin complet du fichier source, requis), Destination Path (chemin de destination, requis, accepte les expressions pour un nommage dynamique), Additional Fields (options de copie avancées).

Cas d’usage : Archiver les fichiers traités dans un bucket dédié, dupliquer des templates avant modification, organiser les fichiers par date ou catégorie.

Search a bucket

Cette action recherche et liste les contenus d’un bucket spécifique, vous permettant de vérifier son existence ou d’explorer sa structure avant d’effectuer d’autres opérations.

Paramètres de configuration : Credential to connect with (identifiants IAM, requis), Resource (fixé sur « Bucket »), Operation (fixé sur « Search »), Bucket Name (nom du bucket à rechercher, requis), Return All (interrupteur pour retourner tous les résultats, optionnel), Limit (nombre maximum de résultats, optionnel, valeur numérique), Additional Fields (options supplémentaires de filtrage).

Cas d’usage : Vérifier l’existence d’un bucket avant d’y uploader des fichiers, lister le contenu d’un bucket pour un audit automatisé, rechercher des fichiers spécifiques avant traitement.

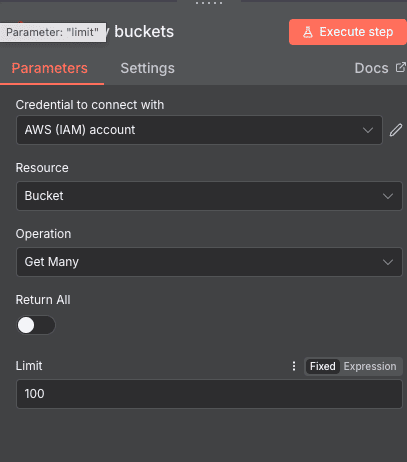

AWS S3: Get Many Buckets

Cette action récupère la liste de tous les buckets disponibles dans votre compte AWS. Parfaite pour des dashboards de monitoring ou des workflows de vérification.

Paramètres de configuration : Credential to connect with (identifiants IAM, requis), Resource (fixé sur « Bucket »), Operation (fixé sur « Get Many »), Return All (booléen pour récupérer tous les buckets, optionnel), Limit (limite le nombre de buckets retournés, requis si Return All désactivé).

Cas d’usage : Générer un inventaire automatique de vos ressources S3, alimenter un dashboard de monitoring des coûts, vérifier la conformité des buckets existants.

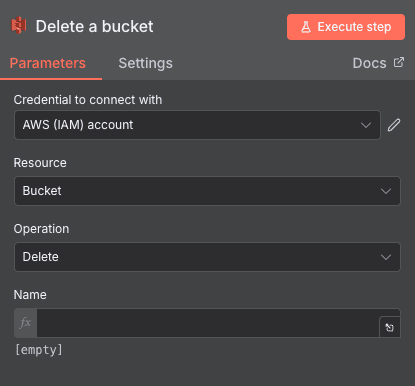

Delete a bucket

Cette action supprime un bucket S3 existant. Elle est idéale pour automatiser le nettoyage de ressources obsolètes ou la suppression de buckets temporaires après utilisation.

Paramètres de configuration : Credential to connect with (sélection des identifiants IAM, requis), Resource (fixé sur « Bucket »), Operation (fixé sur « Delete »), Name (nom exact du bucket à supprimer, requis, le bucket doit être vide pour que la suppression réussisse).

Cas d’usage typiques : Supprimer les buckets de staging après mise en production, nettoyer automatiquement les ressources de test, désactiver l’espace de stockage lors de la clôture d’un compte client.

Download a file

Cette action télécharge un fichier depuis S3 pour l’utiliser dans la suite de votre workflow — transformation, envoi par email, import dans une autre application.

Paramètres de configuration : Credential to connect with (identifiants IAM, requis), Resource (fixé sur « File »), Operation (fixé sur « Download »), Bucket Name (nom du bucket source, requis), File Key (chemin complet du fichier dans le bucket, requis), Put Output File in Field (nom du champ binaire où stocker le fichier téléchargé, requis).

Cas d’usage : Récupérer des templates stockés dans S3 pour génération de documents, télécharger des fichiers de configuration pour des traitements, intégrer des assets S3 dans des emails automatisés.

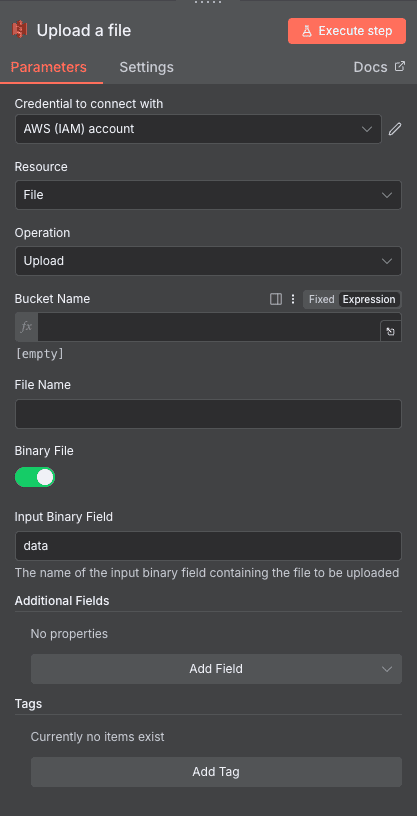

Upload a file

Action centrale de l’intégration, elle vous permet d’uploader n’importe quel fichier vers un bucket S3. C’est probablement l’action que vous utiliserez le plus dans vos workflows no-code d’automatisation.

Paramètres de configuration : Credential to connect with (identifiants IAM, requis), Resource (fixé sur « File »), Operation (fixé sur « Upload »), Bucket Name (nom du bucket de destination, requis, accepte les expressions), File Name (nom du fichier dans S3, requis), Binary File (interrupteur indiquant si c’est un fichier binaire, optionnel), Input Binary Field (nom du champ binaire contenant les données, requis si Binary File activé), Additional Fields (métadonnées, tags, options de chiffrement), Tags (ajout de tags pour l’organisation, optionnel).

Cas d’usage typiques : Sauvegarder automatiquement les pièces jointes d’emails, archiver les rapports générés par vos outils, uploader les exports de bases de données pour backup, stocker les assets uploadés par vos utilisateurs.

Delete a folder

Cette action supprime un dossier et potentiellement son contenu d’un bucket S3.

Paramètres de configuration : Credential to connect with (identifiants IAM, requis), Resource (fixé sur « Folder »), Operation (fixé sur « Delete »), Bucket Name (nom du bucket, requis), Folder Key (chemin du dossier à supprimer, requis, accepte les expressions).

Cas d’usage : Nettoyer les dossiers de travail temporaires, supprimer l’arborescence d’un projet archivé, automatiser la purge des dossiers obsolètes.

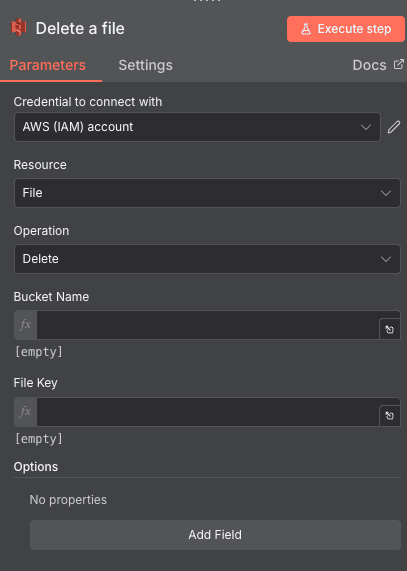

Delete a file

Cette action supprime un fichier spécifique d’un bucket S3. Essentielle pour le nettoyage automatique et la gestion du cycle de vie des fichiers.

Paramètres de configuration : Credential to connect with (identifiants IAM, requis), Resource (fixé sur « File »), Operation (fixé sur « Delete »), Bucket Name (nom du bucket contenant le fichier, requis), File Key (chemin exact du fichier à supprimer, requis), Options (section actuellement vide).

Cas d’usage : Supprimer les fichiers temporaires après traitement, nettoyer les anciennes versions de documents, appliquer une politique de rétention automatique.

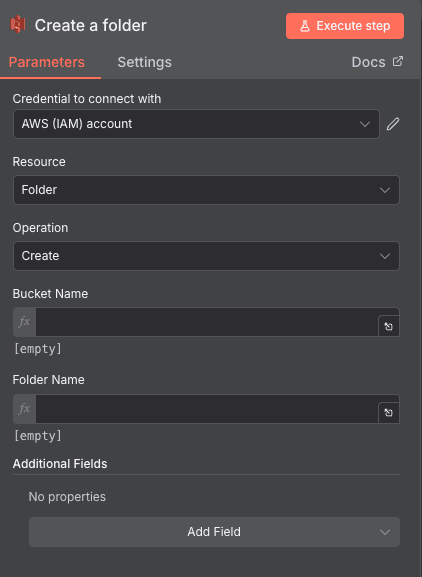

Create a folder

Cette action crée un nouveau dossier (préfixe) dans un bucket S3 pour organiser vos fichiers.

Paramètres de configuration : Credential to connect with (identifiants IAM, requis), Resource (fixé sur « Folder »), Operation (fixé sur « Create »), Bucket Name (nom du bucket, requis), Folder Name (nom du dossier à créer, requis), Additional Fields (options supplémentaires).

Cas d’usage : Créer une arborescence pour chaque nouveau projet, organiser les uploads par date automatiquement, structurer les backups par source de données.

Get many files

Cette action récupère la liste des fichiers présents dans un bucket, avec possibilité de pagination. Idéale pour les traitements batch ou les inventaires.

Paramètres de configuration : Credential to connect with (identifiants IAM, requis), Resource (fixé sur « File »), Operation (fixé sur « Get Many »), Bucket Name (nom du bucket à explorer, requis), Return All (booléen pour récupérer tous les fichiers, optionnel), Limit (nombre maximum de fichiers, optionnel, défaut 100), Options (filtres et options supplémentaires).

Cas d’usage : Lister les fichiers à traiter dans un workflow batch, générer un rapport d’inventaire des assets, identifier les fichiers à archiver ou supprimer.

Get many folders

Cette action liste les dossiers présents dans un bucket, permettant d’explorer la structure de stockage.

Paramètres de configuration : Credential to connect with (identifiants IAM, requis), Resource (fixé sur « Folder »), Operation (fixé sur « Get Many »), Bucket Name (nom du bucket, requis), Return All (booléen pour tout récupérer, optionnel), Limit (nombre maximum de dossiers, optionnel, défaut 100), Options (filtres additionnels).

Cas d’usage : Auditer la structure d’un bucket, identifier les dossiers vides à nettoyer, générer une cartographie des ressources.

BESOIN D’AIDE POUR AUTOMATISER AWS S3 AVEC N8N ?

On revient vers vous en quelques minutes ✔

QUESTIONS FRÉQUENTES SUR L’INTÉGRATION AWS S3 N8N

L'intégration AWS S3 n8n est-elle gratuite ?

L'intégration AWS S3 est native dans n8n et disponible dans toutes les versions, y compris la version community auto-hébergée gratuite. Cependant, vous devez disposer d'un compte AWS actif, et les opérations S3 sont facturées selon la tarification standard d'Amazon — stockage, requêtes et transferts de données. Pour optimiser vos coûts, limitez les actions "Get Many" avec le paramètre Limit et préférez les opérations ciblées aux scans complets de bucket.

Quelles données puis-je synchroniser entre AWS S3 et n8n ?

Avec les 12 actions disponibles, vous pouvez manipuler tous les types de données stockables dans S3 : fichiers binaires (images, PDFs, archives), fichiers texte (CSV, JSON, logs), documents, backups de bases de données, assets media... n8n gère nativement les fichiers binaires et peut les transférer vers/depuis S3 pour les connecter à vos autres applications. Vous pouvez également gérer les métadonnées, tags et la structure de dossiers de vos buckets.

Combien de temps prend la configuration de l'intégration AWS S3 n8n ?

La configuration initiale prend généralement 5 à 10 minutes si vous avez déjà un compte AWS. L'étape la plus longue est la création de l'utilisateur IAM avec les bonnes permissions — comptez 3-5 minutes. Une fois les credentials configurés dans n8n, chaque nouvelle action S3 dans vos workflows ne prend que quelques secondes à paramétrer grâce à l'interface visuelle. Pour un premier workflow fonctionnel (upload automatique de fichiers par exemple), comptez 15-20 minutes au total.