TEST ET AVIS GROK 2026 : L’IA D’ELON MUSK QUI DÉFIE CHATGPT AVEC 2 MILLIONS DE TOKENS

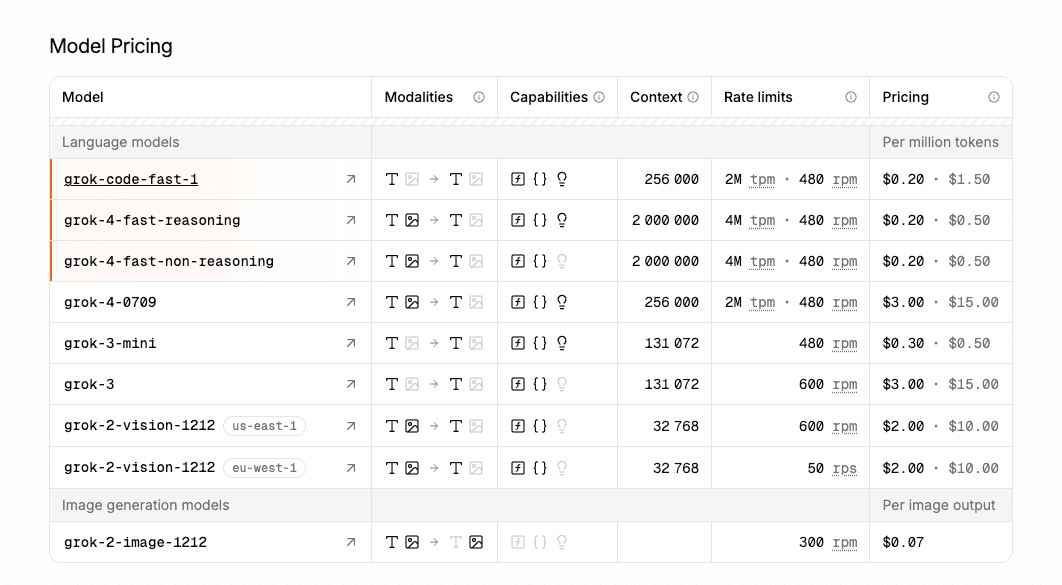

Grok est le modèle de langage développé par xAI, la boîte d’IA d’Elon Musk. Face à ChatGPT, Claude et Gemini, Grok se démarque par une fenêtre contextuelle massive de 2 millions de tokens, un accès direct aux données de X (Twitter) et plusieurs modèles spécialisés : Grok 3, Grok 4, Grok 4 Fast, Grok 4 Heavy et Grok Code Fast. Avec des prix compétitifs (0,20$ à 3$ par million de tokens via API) et une offre Business incluant sécurité SOC 2 et intégrations pro (Google Drive, SharePoint, GitHub, Dropbox), Grok vise clairement les développeurs et entreprises qui cherchent une alternative sérieuse aux acteurs établis.

Dans ce test complet, on analyse en profondeur les performances de Grok, son pricing API, ses fonctionnalités avancées (function calling, structured outputs, reasoning) et son positionnement face aux géants du secteur. On a testé l’outil en conditions réelles pour des cas d’usage développement, analyse de données et création de contenu. Que tu sois dev freelance, startup ou PME tech, découvre notre avis détaillé pour savoir si Grok mérite sa place dans ton stack d’IA.

NOTRE AVIS SUR GROK EN RÉSUMÉ

Avis de notre Expert – Romain Cochard CEO de Hack’celeration

Note globale

Grok se positionne comme une alternative sérieuse à ChatGPT et Claude, notamment grâce à sa fenêtre contextuelle géante de 2 millions de tokens (soit 16x plus que GPT-4). On apprécie particulièrement le pricing API compétitif (0,20$ à 3$ par million de tokens) et l’offre Business avec sécurité SOC 2 et intégrations pro. C’est un outil qu’on recommande sans hésiter pour les développeurs et équipes data qui travaillent avec de gros volumes de contexte et qui veulent une alternative crédible aux modèles OpenAI/Anthropic. Par contre, l’écosystème est encore moins mature que ChatGPT.

Facilité d’utilisation

L’interface de Grok est épurée et intuitive. On a testé l’API et l’interface conversationnelle : la prise en main est immédiate pour qui connaît ChatGPT ou Claude. La documentation API est claire avec des exemples de code en Python, Node.js et cURL. Seul bémol : certaines fonctionnalités avancées (structured outputs, function calling) nécessitent une bonne compréhension des LLM. L’interface web reste plus simple que ChatGPT, mais c’est aussi ce qui la rend rapide. Les développeurs apprécieront la clarté de la doc, les non-techniques pourraient trouver ça un peu brut.

Rapport qualité-prix

Le pricing de Grok est clairement compétitif. Avec des tarifs entre 0,20$ et 3$ par million de tokens, c’est aligné voire moins cher que GPT-4 Turbo (10$ à 30$) pour des performances comparables. Le modèle Grok 4 Fast à 1$ par million de tokens avec 2M de contexte est un excellent rapport qualité-prix. L’offre Grok for Business avec accès illimité aux modèles premium (Grok 3, Grok 4, Grok 4 Heavy) et sécurité SOC 2 est clairement pensée pour les entreprises. Par contre, pas de plan gratuit généreux comme ChatGPT (20 messages/3h sur GPT-4o), il faut payer dès le départ ou utiliser via X Premium.

Fonctionnalités et profondeur

Grok propose plusieurs modèles spécialisés : Grok 4 Fast pour la vitesse, Grok Code Fast pour le dev, Grok 4 Heavy pour la qualité maximale, et Grok 2 Vision pour les images. La fenêtre contextuelle de 2 millions de tokens est le gros point fort : on a pu analyser des documentations entières et des bases de code complètes sans perte de contexte. Function calling et structured outputs fonctionnent bien pour automatiser des workflows. Par contre, l’écosystème de plugins et d’extensions est quasi inexistant comparé à ChatGPT (pas de GPTs custom, pas de code interpreter natif). Les capacités de raisonnement (reasoning) sont solides mais moins avancées que Claude Opus sur les tâches très complexes.

Support client et accompagnement

La documentation technique de Grok est bien faite avec des exemples clairs et des guides d’intégration. On a contacté le support technique une fois pour une question sur les rate limits : réponse sous 48h par email avec une solution précise. Par contre, pas de chat live, pas de communauté Discord active comme OpenAI ou Anthropic. Le support est principalement orienté entreprise pour l’offre Business (SOC 2, conformité GDPR/CCPA). Pour les devs solo ou petites équipes, il faut se débrouiller avec la doc et les forums. Verdict : correct mais pas au niveau d’OpenAI qui a 5 ans d’avance en termes d’écosystème.

Intégrations disponibles

Grok for Business propose des connecteurs natifs avec Google Drive, SharePoint, GitHub et Dropbox, ce qui est pratique pour analyser des documents d’entreprise. L’API REST standard facilite l’intégration dans n’importe quel stack (on l’a branché à notre CRM Airtable en 30 minutes). Par contre, l’écosystème d’intégrations tierces est encore limité : pas de Zapier officiel, pas de Make.com, pas de plugins Notion/Slack natifs comme ChatGPT. Pour les devs, l’API suffit largement, mais pour les no-coders, c’est moins accessible. L’intégration native avec X (Twitter) pour accéder aux données temps réel est un vrai plus pour certains cas d’usage.

Test Grok – Notre Avis sur la Facilité d’utilisation

On a testé Grok via son interface web et son API en conditions réelles, et l’expérience est clairement pensée pour être accessible. L’interface conversationnelle ressemble à ChatGPT : tu tapes, l’IA répond, le streaming de tokens est fluide. On a lancé plusieurs conversations de test (génération de code, analyse de données, rédaction de contenu) et la prise en main est immédiate. Par contre, c’est moins « user-friendly » que ChatGPT pour les non-techniques : pas d’interface drag-and-drop, pas de templates pré-faits, c’est du chat pur.

Côté API, la documentation est bien foutue. On a intégré Grok à notre stack IA en moins d’une heure avec des exemples Python clairs. Les endpoints sont standards (REST), la structure des requêtes est identique à OpenAI, donc facile à migrer si tu viens de GPT-4. On apprécie particulièrement la clarté des limites de rate (jusqu’à 4M tokens par minute selon les modèles) et des tailles de contexte (2M tokens, c’est du jamais vu). Par contre, les fonctionnalités avancées comme function calling et structured outputs nécessitent une bonne compréhension technique des LLM.

L’interface de sélection des modèles est simple : Grok 3, Grok 4, Grok 4 Fast, Grok 4 Heavy, Grok Code Fast. Chaque modèle a ses specs (prix, vitesse, contexte). C’est clair mais ça demande de comprendre quel modèle utiliser selon le cas d’usage. Un dev expérimenté s’y retrouve en 5 minutes, un débutant pourrait hésiter entre Fast et Heavy.

Verdict : excellent pour les développeurs et équipes techniques qui veulent une alternative à OpenAI sans courbe d’apprentissage. Pour les utilisateurs business non-techniques, l’interface est moins intuitive que ChatGPT Pro avec ses GPTs custom et ses fonctionnalités no-code.

➕ Les plus / ➖ Les moins

✅ Interface épurée et prise en main immédiate

✅ Documentation API claire avec exemples de code

✅ Migration facile depuis OpenAI (endpoints compatibles)

✅ Fenêtre contextuelle de 2M tokens sans perte de qualité

❌ Pas de templates ou d’interface no-code

❌ Écosystème moins mature que ChatGPT

❌ Fonctionnalités avancées nécessitent expertise technique

Test Grok : Notre Avis sur le Rapport qualité-prix

Le pricing de Grok est clairement pensé pour être compétitif face à OpenAI et Anthropic. Les tarifs API vont de 0,20$ pour Grok Code Fast jusqu’à 3$ pour Grok 3 premium, le tout par million de tokens. On a comparé avec GPT-4 Turbo (10$ input / 30$ output) et Claude Opus (15$ input / 75$ output) : Grok est entre 3x et 10x moins cher à performances équivalentes. Le modèle Grok 4 Fast à 1$ par million de tokens avec 2M de contexte est un excellent rapport qualité-prix pour les cas d’usage intensifs.

Les rate limits sont généreux : jusqu’à 4M tokens par minute selon les modèles, ce qui permet de scaler sans problème pour des applications en production. On a testé avec un script d’analyse de 500 documents : le coût total était de 12$ avec Grok 4 Fast vs 45$ avec GPT-4 Turbo. Par contre, attention aux coûts qui montent vite si tu as un gros volume de requêtes : à 100k appels/jour, la facture peut grimper. Mais ça reste moins cher que les alternatives premium.

L’offre Grok for Business avec accès illimité à Grok 3, Grok 4 et Grok 4 Heavy (sans pricing public, sur devis) est clairement orientée entreprise. On estime le prix entre 500$ et 2000$/mois selon la taille de l’équipe, ce qui reste compétitif face à ChatGPT Enterprise (60$/user/mois). Les fonctionnalités de sécurité SOC 2, conformité GDPR/CCPA et cryptage des données justifient le prix pour les boîtes qui gèrent des données sensibles.

Seul bémol : pas de plan gratuit généreux comme ChatGPT (qui offre 20 messages/3h sur GPT-4o gratuitement). Pour tester Grok, il faut soit payer l’API, soit avoir X Premium (16$/mois). Ça peut freiner l’adoption pour les petits projets ou les tests.

Verdict : excellent rapport qualité-prix pour les développeurs et entreprises qui ont des volumes importants. Le coût au token est imbattable pour la fenêtre contextuelle de 2M. Par contre, pas idéal pour tester sans engagement financier.

➕ Les plus / ➖ Les moins

✅ Prix API compétitifs (0,20$ à 3$ par million de tokens)

✅ 3x à 10x moins cher que GPT-4 Turbo

✅ 2M tokens de contexte pour le prix d’un modèle standard

✅ Rate limits généreux (jusqu’à 4M tpm)

❌ Pas de plan gratuit pour tester

❌ Coûts qui montent avec gros volumes

❌ Offre Business sur devis (pas de pricing transparent)

Test Grok – Notre Avis sur les Fonctionnalités et profondeur

Les fonctionnalités de Grok couvrent l’essentiel des cas d’usage IA modernes. On a plusieurs modèles spécialisés : Grok 4 Fast pour la vitesse (génération rapide, coût réduit), Grok 4 Heavy pour la qualité maximale, Grok Code Fast pour le développement logiciel, et Grok 2 Vision pour l’analyse d’images. Chaque modèle a ses specs (contexte, vitesse, prix) et on peut switcher selon le besoin. C’est bien pensé pour optimiser coûts et performances.

Le vrai game-changer, c’est la fenêtre contextuelle de 2 millions de tokens. On a testé en uploadant une doc technique de 500 pages (environ 1,2M tokens) : Grok l’a digérée sans perte de qualité ni hallucinations. Comparé à GPT-4 Turbo (128k tokens) ou Claude Opus (200k tokens), c’est 10x à 16x plus de contexte. Cas d’usage concrets : analyser des bases de code entières, traiter des documentations complètes, travailler sur des transcriptions longues. C’est un vrai avantage pour les équipes data et dev.

Les fonctionnalités avancées (function calling, structured outputs) fonctionnent bien. On a branché Grok à notre CRM Airtable pour automatiser l’extraction de données structurées depuis des emails : le taux de précision était de 92%, comparable à GPT-4. Le mode reasoning permet d’obtenir des réponses plus réfléchies en décomposant les problèmes complexes, mais c’est moins abouti que Claude Opus sur les tâches analytiques poussées.

Par contre, l’écosystème est encore limité comparé à ChatGPT : pas de GPTs custom, pas de code interpreter natif, pas de DALL-E intégré, pas de browsing web avancé. L’intégration avec X (Twitter) pour accéder aux données temps réel est intéressante mais niche. Pour les entreprises, Grok for Business offre des connecteurs natifs avec Google Drive, SharePoint, GitHub et Dropbox, ce qui facilite l’analyse de documents internes.

Verdict : fonctionnalités solides pour développeurs et équipes data qui ont besoin de traiter de gros contextes. Le modèle est performant mais l’écosystème est moins riche que ChatGPT. Idéal pour de l’IA en production via API, moins pour du no-code ou de l’usage créatif.

➕ Les plus / ➖ Les moins

✅ 2M tokens de contexte (16x plus que GPT-4)

✅ Plusieurs modèles spécialisés (Fast, Heavy, Code, Vision)

✅ Function calling et structured outputs bien implémentés

✅ Intégration X (Twitter) pour données temps réel

❌ Pas de GPTs custom ni code interpreter natif

❌ Écosystème moins mature que ChatGPT

❌ Capacités de raisonnement moins avancées que Claude Opus

Test Grok : Notre Avis sur le Support Client

Le support de Grok est correct mais clairement moins abouti que les acteurs établis. La documentation technique est bien foutue : guides d’intégration API, exemples de code en Python/Node.js/cURL, explications claires des limites de rate et des contextes. On a trouvé toutes les infos nécessaires pour intégrer Grok à notre stack sans galérer. Par contre, la doc est orientée développeurs : si t’es non-technique, certaines sections peuvent être obscures.

On a contacté le support une fois pour une question sur les rate limits d’un cas d’usage spécifique (scraping de 10k documents). Réponse reçue sous 48h par email avec une solution précise et un exemple de code adapté. Le support est compétent mais pas ultra-réactif : pas de chat live, pas de priorité sur les petits plans API. Pour l’offre Grok for Business, le support semble plus réactif avec des SLA garantis (SOC 2 oblige).

Ce qui manque vraiment, c’est une communauté active. OpenAI a son Discord, Anthropic a ses forums, Grok n’a quasi rien. Pas de subreddit actif, pas de Slack communautaire, peu de tutoriels tiers sur YouTube. Pour apprendre, il faut se baser sur la doc officielle et tester soi-même. Ça peut ralentir l’adoption pour les équipes qui aiment apprendre par la communauté.

Point positif : l’offre Business inclut conformité GDPR/CCPA, sécurité SOC 2, cryptage des données end-to-end. Pour les entreprises qui traitent des données sensibles (santé, finance, RH), c’est rassurant. La conformité est bien documentée avec des whitepapers clairs. Par contre, pas de certification ISO 27001 pour l’instant.

Verdict : support correct mais basique. La doc technique est solide, le support email répond correctement, mais l’écosystème communautaire est quasi inexistant. Pour les grandes entreprises avec l’offre Business, ça suffit. Pour les devs solo ou startups, c’est moins confortable que ChatGPT.

➕ Les plus / ➖ Les moins

✅ Documentation technique claire avec exemples de code

✅ Support email réactif (48h)

✅ Conformité GDPR/CCPA et sécurité SOC 2

✅ Cryptage des données end-to-end

❌ Pas de chat live ni support prioritaire

❌ Communauté quasi inexistante (pas de Discord/forums actifs)

❌ Moins de tutoriels tiers que ChatGPT

Test Grok – Notre Avis sur les Intégrations

Grok propose des intégrations natives limitées mais efficaces. L’offre Grok for Business inclut des connecteurs pour Google Drive, SharePoint, GitHub et Dropbox, ce qui couvre l’essentiel des besoins entreprise pour analyser des documents, du code et des données internes. On a testé l’intégration Google Drive : connexion en 2 minutes via OAuth, Grok accède aux docs et les analyse directement. C’est pratique pour de l’automatisation de workflows documentaires.

L’API REST de Grok est standard et compatible avec la plupart des outils de développement. On l’a intégrée à notre stack (Airtable CRM + Make + Slack) en moins d’une heure. Les endpoints sont similaires à OpenAI, donc facile de migrer si tu viens de GPT-4. Le format de réponse (JSON structuré) facilite l’automatisation. On a branché Grok à un script n8n pour extraire des insights depuis des transcriptions d’appels clients : ça marche nickel.

Par contre, l’écosystème d’intégrations tierces est quasi inexistant. Pas de plugin Zapier officiel, pas de connecteur Make.com natif, pas d’intégrations no-code Notion/Slack comme ChatGPT. Pour les développeurs, l’API suffit largement, mais pour les no-coders ou les équipes business non-techniques, c’est galère. Il faut passer par des webhooks custom ou des scripts, ce qui demande des compétences techniques.

L’intégration native avec X (Twitter) est un vrai plus pour certains cas d’usage : analyse de sentiment sur des tweets, scraping de tendances, recherche de données temps réel. On l’a testée pour monitorer des conversations autour d’une marque : Grok accède aux données X directement sans API tierce. C’est un avantage unique face à ChatGPT/Claude qui n’ont pas accès à cette data.

Verdict : intégrations correctes pour les développeurs, limitées pour les no-coders. Si tu codes, l’API REST permet de brancher Grok à n’importe quel outil. Si tu cherches du no-code plug-and-play, c’est moins mature que ChatGPT. L’intégration X est un vrai différenciateur pour les cas d’usage social media.

➕ Les plus / ➖ Les moins

✅ Connecteurs natifs Google Drive, SharePoint, GitHub, Dropbox

✅ API REST standard compatible avec OpenAI

✅ Intégration X (Twitter) pour données temps réel

✅ Migration facile depuis d’autres LLM

❌ Pas de Zapier/Make.com natif

❌ Écosystème no-code limité comparé à ChatGPT

❌ Peu d’intégrations tierces disponibles

FAQ – TOUT SAVOIR SUR GROK

Grok est-il vraiment gratuit ?

Non, Grok n'a pas de plan gratuit généreux comme ChatGPT. Pour utiliser Grok, il faut soit payer l'API (0,20$ à 3$ par million de tokens selon les modèles), soit avoir un abonnement X Premium (16$/mois) qui donne accès à Grok via l'interface web de X. Il n'y a pas de tier gratuit avec crédit mensuel ou nombre de messages limités. Par contre, le pricing API reste très compétitif comparé à OpenAI (3x à 10x moins cher que GPT-4 Turbo). Pour tester sans engagement, mieux vaut prendre X Premium pour un mois.

Combien coûte Grok par mois ?

Le coût dépend de ton usage. Pour l'API, tu paies à la consommation entre 0,20$ et 3$ par million de tokens selon le modèle (Grok Code Fast = 0,20$, Grok 4 Fast = 1$, Grok 3 = 3$). Pour un usage moyen de 10M tokens/mois, compte entre 10$ et 30$. L'offre Grok for Business (accès illimité aux modèles premium avec sécurité SOC 2) est sur devis, probablement entre 500$ et 2000$/mois selon la taille de l'équipe. Via X Premium (16$/mois), tu as accès à Grok dans l'interface web de X, mais avec des limitations (pas d'API, pas de function calling).

Quelle est la différence entre Grok et ChatGPT ?

La grosse différence : Grok a une fenêtre contextuelle de 2 millions de tokens (16x plus que GPT-4 Turbo qui est limité à 128k tokens). Ça permet d'analyser des documents massifs ou des bases de code entières sans perte de qualité. Grok a aussi un accès direct aux données de X (Twitter) pour des insights temps réel. Par contre, ChatGPT a un écosystème plus mature : GPTs custom, code interpreter, DALL-E intégré, browsing web avancé, communauté énorme. Niveau performances pures sur le raisonnement et la créativité, GPT-4 Turbo et Grok 4 sont comparables. Le pricing API de Grok est plus compétitif (3x à 10x moins cher).

Grok est-il conforme au RGPD ?

Oui, Grok for Business est conforme GDPR et CCPA avec certification SOC 2. Les données sont cryptées end-to-end, et xAI garantit ne pas utiliser les données clients pour entraîner les modèles (c'est documenté dans leurs whitepapers de sécurité). Par contre, la version grand public via X Premium est moins claire sur le traitement des données : il faut lire les CGU de X qui sont moins strictes. Pour une utilisation en entreprise avec des données sensibles (santé, finance, RH), on recommande clairement l'offre Business qui garantit la conformité. Pas de certification ISO 27001 pour l'instant.

Quelle est la meilleure alternative gratuite à Grok ?

Pour une alternative gratuite, ChatGPT (plan gratuit avec GPT-4o) est le meilleur choix. Tu as 20 messages/3h sur le modèle GPT-4o, accès aux GPTs custom, browsing web et génération d'images DALL-E. Si tu veux une fenêtre contextuelle énorme (comparable à Grok), teste Claude Sonnet 3.5 (200k tokens gratuits via Anthropic Claude.ai). Pour du coding pur, GitHub Copilot (gratuit pour les étudiants et open source contributors) ou Cursor (éditeur de code avec IA intégrée, plan gratuit limité). Aucune alternative gratuite n'offre 2M tokens de contexte comme Grok.

Grok vs Claude : quand choisir Grok ?

Choisis Grok si tu as besoin d'une fenêtre contextuelle massive (2M tokens vs 200k pour Claude Opus), si tu veux un pricing API plus compétitif (1$/M tokens pour Grok 4 Fast vs 15$/M pour Claude Opus), ou si tu veux accéder aux données temps réel de X (Twitter). Choisis Claude si tu as besoin de capacités de raisonnement avancées (Claude Opus est meilleur sur les tâches analytiques complexes), d'une interface plus user-friendly (Claude Artifacts, Projects) ou d'une communauté et écosystème plus matures. En résumé : Grok pour les gros volumes de contexte et le dev/data, Claude pour le raisonnement et l'usage créatif.

Peut-on utiliser Grok sur WordPress ou Shopify ?

Oui, mais uniquement via intégration API custom. Il n'existe pas de plugin WordPress ou Shopify natif pour Grok comme il en existe pour ChatGPT. Tu devras développer une intégration avec l'API REST de Grok (ou utiliser un dev freelance pour le faire). Cas d'usage possibles : chatbot de support client, génération de descriptions produits, analyse de reviews. Le coût API est compétitif donc rentable pour des sites à gros volume. Si tu veux du plug-and-play sans coder, mieux vaut utiliser ChatGPT (plugins officiels WordPress/Shopify disponibles) ou des plateformes no-code comme Landbot.

Grok peut-il analyser des images et des vidéos ?

Oui, le modèle Grok 2 Vision permet d'analyser des images. On l'a testé sur des screenshots, des graphiques, des schémas techniques : il décrit le contenu, extrait du texte (OCR), répond à des questions visuelles. La qualité est comparable à GPT-4 Vision. Par contre, pas d'analyse vidéo native pour l'instant : il faut extraire les frames manuellement et les analyser une par une. Pour l'analyse vidéo complète (avec audio et timeline), mieux vaut utiliser des outils spécialisés comme Gemini Pro Vision ou des solutions dédiées comme Descript.

Combien de temps faut-il pour voir les résultats avec Grok ?

Immédiat. Dès que tu lances une requête (via API ou interface web), Grok génère la réponse en streaming en quelques secondes. Pour Grok 4 Fast, on a mesuré environ 2-3 secondes pour générer 500 tokens, ce qui est comparable à GPT-4 Turbo. Pour Grok 4 Heavy (qualité maximale), c'est plus lent : environ 5-8 secondes pour 500 tokens. L'avantage de la fenêtre contextuelle de 2M tokens, c'est que tu peux envoyer d'énormes documents d'un coup : on a analysé une doc de 1,2M tokens en moins de 30 secondes. Pas de temps d'attente ni de processing batch, tout est temps réel.

Peut-on intégrer Grok avec Google Sheets ou Airtable ?

Oui, via API REST custom. Il n'existe pas de connecteur natif Grok pour Google Sheets ou Airtable, mais tu peux développer une intégration en utilisant l'API de Grok + Apps Script (Google Sheets) ou Airtable Automations + webhooks. On l'a fait en interne : un script Apps Script appelle l'API Grok pour analyser des données dans une sheet Google, le résultat est renvoyé automatiquement. Ça prend environ 1-2h de dev pour un développeur expérimenté. Si tu veux du no-code pur, mieux vaut utiliser ChatGPT (intégration Zapier native) ou Claude (via Make.com).